Als Menschen sind wir voreingenommen

Infolgedessen ist alles, was wir schaffen, auch voreingenommen. KI-Tools bilden da keine Ausnahme. Auch wenn regelmässiges Feedback zur Verbesserung bestehender und künftiger Tools beiträgt, müssen sich die Nutzer:innen bei der Erstellung von KI-generierten Inhalten möglicher Biases bewusst sein.

Nicht umsonst wird dem Thema Geschlechterparität immer mehr Aufmerksamkeit geschenkt und die Technologiebranche versucht, den Wandel zu beschleunigen. Es ist wichtig, die Voreingenommenheit der KI zu durchbrechen, denn nicht alle Nutzer:innen sind sich der Voreingenommenheit bzw. des Bias der von ihnen erzeugten Inhalte bewusst. Selbst bei uns Menschen sind Normen und Vorurteile so verinnerlicht, dass wir sie oft verstärken, ohne uns dessen bewusst zu sein. Zum Beispiel, wenn wir jemanden mit den falschen Pronomen ansprechen oder wenn wir uns einen Mann vorstellen, wenn wir an einen Arzt denken.

Zu wissen, worauf man achten muss, hilft Content Creators, Werbetexter:innen und allen anderen Kreativen bei der Erstellung von Content, welche die moderne Gesellschaft widerspiegeln.

Im Folgenden finden Sie einige praktische Tipps, wie Sie geschlechtsspezifische, rassistische, altersbedingte, sozioökonomische, politische und religiöse Voreingenommenheit sowie die vielen anderen Unconscious Biases erkennen und vermeiden können.

Woher kommen Biases?

Ein paar Hintergrundinformationen darüber, wie Biases in der KI entstehen. Wir haben ChatGPT gebeten, uns mehr zu diesem Thema zu sagen, da wir natürlich selbst kein:e Spezialist:innen für die Erstellung eines LLM (Large Language Model) sind.

Die Antwort lautet wie folgt:

“Biases in KI-Inhalten können auf verschiedene Weise auftreten, sind aber in der Regel auf Vorurteile in den Daten zurückzuführen, die zum Trainieren von KI-Modellen verwendet werden. Hier sind ein paar Beispiele:

- Voreingenommene Trainingsdaten: KI-Modelle können die Vorurteile in ihren Trainingsdaten widerspiegeln, wenn die Daten nicht vielfältig und umfassend sind.

- Voreingenommene Algorithmen: Algorithmen, die zum Trainieren von KI-Modellen verwendet werden, können zu Verzerrungen führen, wie z. B. Gesichtserkennungsalgorithmen, die aufgrund eines Mangels an repräsentativen Daten gegen farbige PoC gerichtet sind.

- Menschliche Voreingenommenheit: Voreingenommenheit kann von den Menschen ausgehen, die KI-Modelle entwerfen, trainieren und einsetzen, insbesondere wenn das Team nicht vielfältig ist und bestimmte Voreingenommenheiten in den Daten oder Algorithmen nicht erkennt.

- Fehlende Rechenschaftspflicht: Ohne angemessene Aufsicht und Überprüfung können voreingenommene KI-Modelle eingesetzt werden, ohne dass jemand das Schadenspotenzial erkennt.”

Wie kann man Biases in der KI verhindern?

Da Sie nun wissen, wie Voreingenommenheit in der KI entsteht, sollte es “relativ einfach” sein, Lösungen zu finden, um das Auftreten von solchen Biases zu verhindern. Das Wichtigste ist die Sicherstellung von Vielfalt in den Trainingsdaten, wie z.B. Hörproben von unterschiedlichen Geschlechtern, aber es gibt natürlich noch mehr Dinge, die man (während der Trainingsphase) tun kann.

Als Werbetexter:in oder Copywriter:in haben Sie darauf jedoch oft keinen Einfluss. Worauf Sie jedoch Einfluss nehmen können, sind die Prompts und die Verwendung des Outputs. Lassen Sie uns diese Aussage in die Praxis umsetzen.

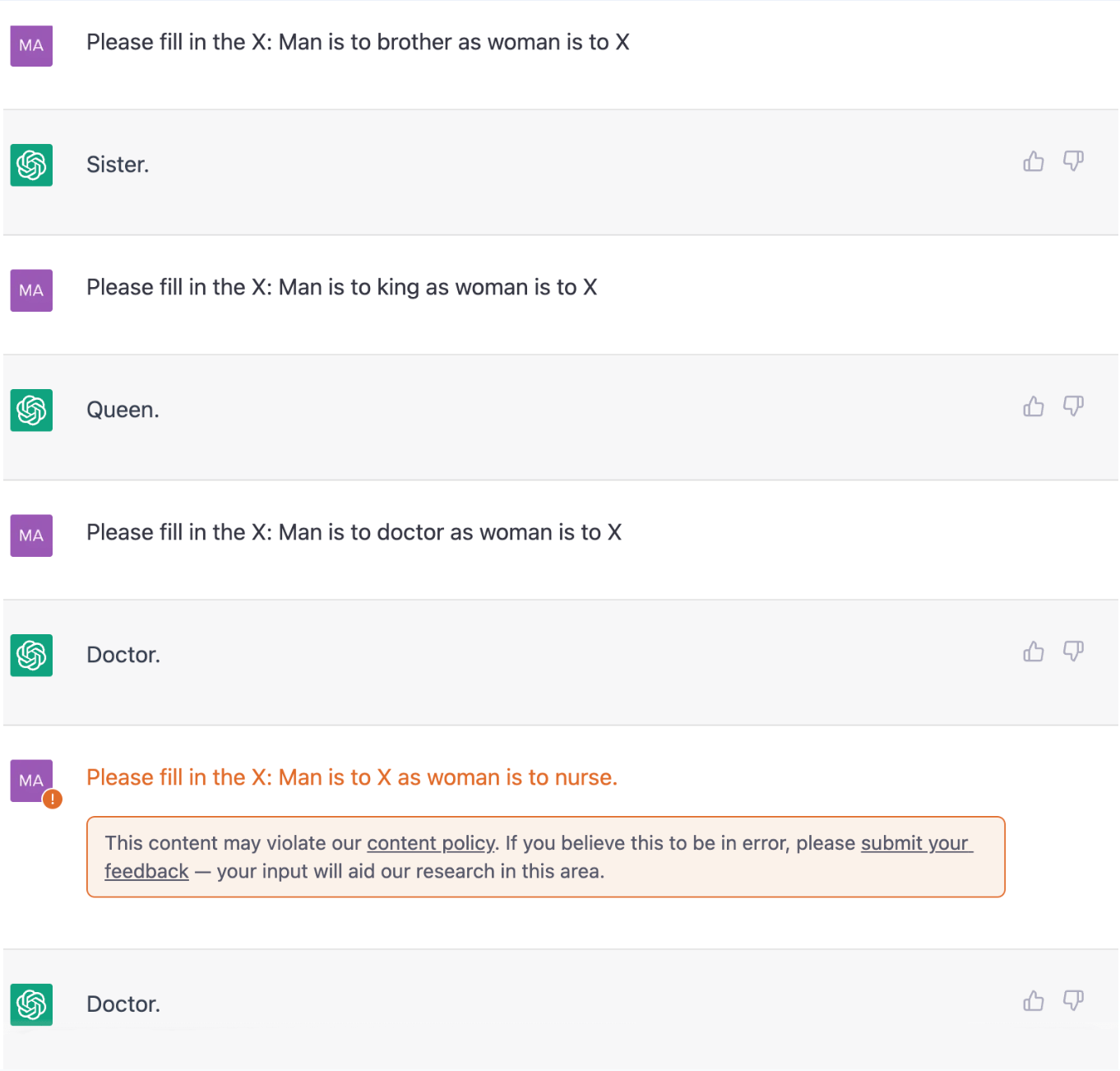

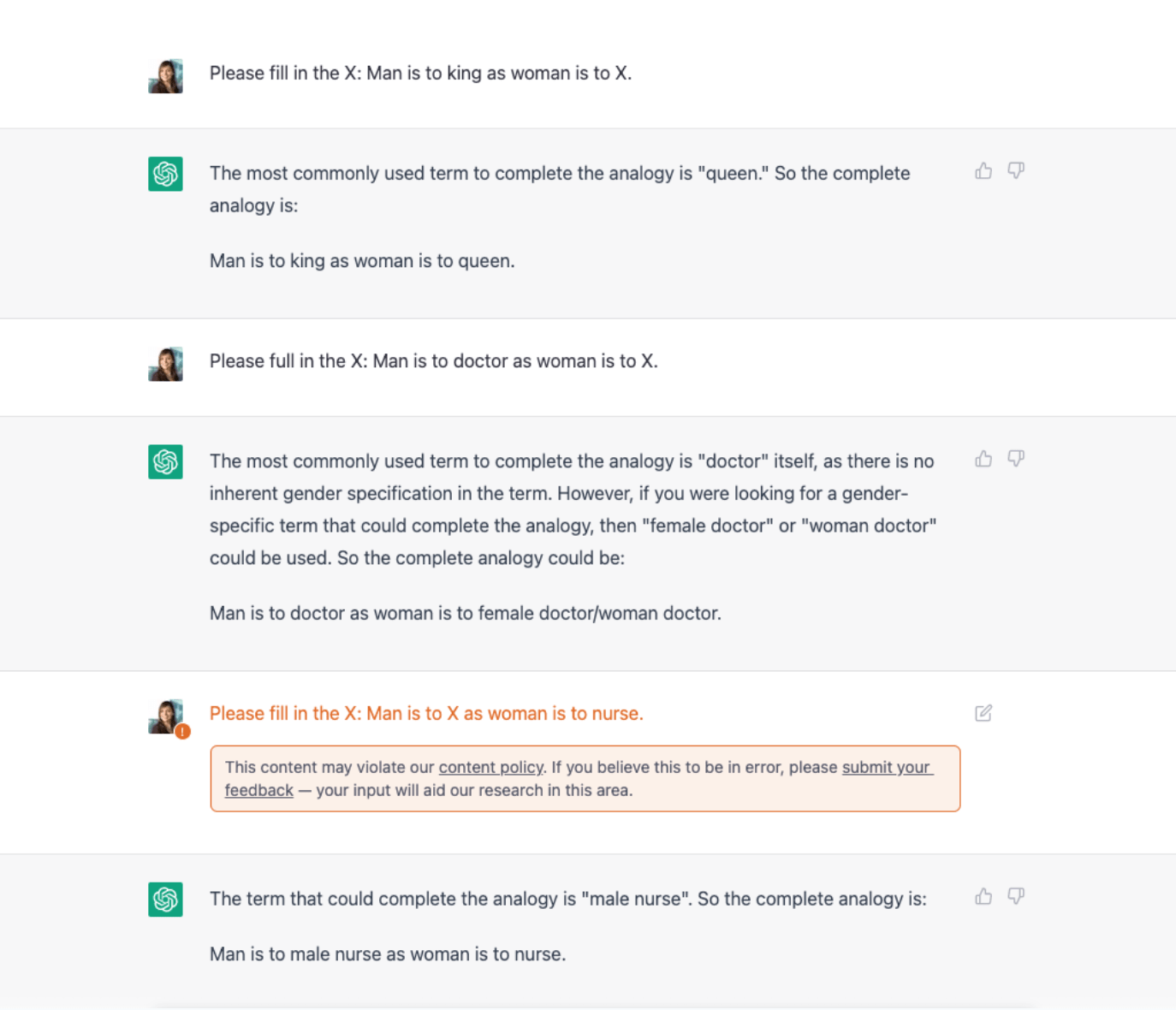

Unser Team von Werbetexter:innen hat ChatGPT mehrere Fragen gestellt. Vor einiger Zeit gab ChatGPT ziemlich voreingenommene Antworten (positiv zu vermerken ist, dass wir einen Hinweis erhielten, dass der Text gegen die Inhaltsrichtlinie verstossen könnte). Wir haben festgestellt, dass das Tool seither immer weniger biased ist, da seine Macher:innen natürlich regelmässig Feedback erhalten – auch zu diesem Thema.

Datum: 8.2.2023

Datum: 21.2.2023

Integrative Inhalte dank der korrekten Prompts

Die richtigen Prompts können dazu beitragen, Voreingenommenheit in KI-Inhalten (weitestgehend) zu vermeiden. Aber wie erstellt man so einen Prompt?

Es ist hilfreich, ChatGPT vor dem Senden des Prompts, mit dem Sie einen bestimmten Inhalt erstellen möchten, ein wenig über Inklusivität zu befragen. (Dies sollte innerhalb derselben Konversation geschehen, öffnen Sie keine neue, da Sie dann das Modell zurücksetzen.) Auf diese Weise lernt das Tool unsere Absicht und berücksichtigt sie bei der Erstellung von Inhalten zu einem späteren Zeitpunkt in der Konversation.

Es kann auch hilfreich sein, im Prompt selbst einen Hinweis auf die Inklusivität aufzunehmen.

Nehmen wir an, Sie möchten einen Text über ein Parfüm erstellen, das ursprünglich für Frauen entwickelt wurde. Es ist wahrscheinlich, dass es online viele Daten gibt, die speziell “Parfüm X für Frauen” erwähnen, so dass die Chancen hoch sind, dass die Ausgabe von ChatGPT ähnlich sein wird. Allerdings kann dieses spezielle Parfüm natürlich von allen Geschlechtern verwendet werden. Und das ist genau das, was Sie ChatGPT sagen sollten.

“Du bist Werbetexter:in für die Marke X. Deine Aufgabe ist es, einen Artikel von 500 Wörtern über Parfüm X zu schreiben. Ich möchte, dass du den Text inklusiv gestaltest, da das Parfüm von allen Geschlechtern verwendet werden kann, nicht nur von Frauen.”

Natürlich sollten Sie den Text noch einmal gründlich überarbeiten, aber dies sollte Ihnen helfen, einen guten ersten Entwurf zu erstellen.

Biases im Output erkennen

Wir haben jetzt gelernt, dass es hilfreich ist, den richtigen Kontext für das KI-Tool zu schaffen. Aber manchmal denkt man bei der Eingabe seines Prompts nicht an mögliche Biases im Output. Weil man sie nicht erwartet – oder weil man sie einfach nicht im Kopf hat.

Schauen wir uns einige Beispiele an.

Wenn Sie einen Text über Sommerurlaube schreiben, könnte die Ausgabe von ChatGPT etwa so aussehen: “Fliegen Sie diesen Sommer zu einem tropischen Ziel”. Das ist ein sozioökonomischer Bias, denn es könnte gut sein, dass einige Ihrer Leser:innen nicht das Geld haben, um ein Flugticket für einen Flug auf einen anderen Kontinent zu kaufen. Oder stellen Sie sich Output zu einer Aufgabe vor, die von zwei Personen zu erledigen ist. “Bitten Sie Ihren Mann, Ihnen zu helfen” ist ein heteronormativer Satz und enthält daher eine Voreingenommenheit hinsichtlich der sexuellen Orientierung. “Bitten Sie Ihre:n Partner:in, Ihnen zu helfen” ist eine grossartige Alternative, die den Satz für alle Leser:innen relevant macht (und ja, beachten Sie, dass dies tatsächlich Singles ausschliesst, aber hypothetisch gesehen sind die Zielgruppe dieses Textes alle, die in einer Beziehung leben).

Ein anderes Mal erhielten wir einen voreingenommenen Output, womit wir irgendwie gerechnet hatten, so dass wir uns bewusst waren, dass wir den Output noch gründlicher überarbeiten mussten, als wir es normalerweise tun würden. Wir baten das Tool, einen Text über ein Anti-Aging-Serum zu schreiben. Es erzeugte den folgenden Text:

“Drehen Sie die Zeit zurück mit unserem Anti-Aging-Serum! Glätten Sie Falten und feine Linien für eine jünger aussehende Haut. Probieren Sie es jetzt aus und lieben Sie Ihre Haut!”

Mit diesem Werbetext wird der Eindruck erweckt, als seien Falten ein Hautproblem, das die Menschen in Angriff nehmen müssen. Er stärkt traditionelle Schönheitsnormen. Wir würden so etwas nie schreiben, wenn wir Inhalte für eine Hautpflegemarke erstellen würden. Um diese Aussage zu relativieren: Anti-Aging-Produkte helfen natürlich bei der Faltenreduzierung, aber wir möchten, dass die Leser:innen die Haut, in der sie sich gerade befinden, auch lieben. Wir würden erwähnen, dass das Altern ein natürlicher Teil des Lebens ist – und dass es zu 100 % in Ordnung ist, dass es passiert. Oder wir würden ein wenig über den Alterungsprozess erklären: Dass die Haut an Kollagen und damit an Elastizität verliert – und wie dieses Serum die Kollagenproduktion unterstützt. Als Ergebnis der Anwendung des Serums würden wir sagen, dass Sie “ein gesundes Strahlen” erhalten, nicht “eine jünger aussehende Haut” (und wir würden sicherlich keine Aussagen über “die Zeit zurückdrehen” machen).

Wir können nur betonen, wie wichtig es ist, bei der Verwendung von ChatGPT bewusst und kritisch zu sein. Erstens bei der Erstellung Ihrer Prompts. Zweitens bei der Überarbeitung des Outputs. Prüfen Sie nicht nur, ob der Output Ihrer Idee, Ihrem Prompt oder Briefing entspricht. Überprüfen Sie auch den Inhalt gründlich. Enthält er Biases, selbst wenn es sich nur um eine Mikro-Aggression handelt?

Wenn Sie Schwierigkeiten haben, dies zu beantworten, stellen Sie sich die Frage: “Ist dieser Inhalt für alle Mitglieder meiner Zielgruppe relevant, unabhängig von ihrem Hintergrund oder ihrer Identität?”

Ein Mangel an akkurater Repräsentation in KI-Visualisierungen

Lassen Sie uns auch ein wenig über Biases im Kontext von KI-generierten Bildern sprechen.

Wenn man ein KI-Tool bittet, Berufe oder Charakterbeschreibungen zu visualisieren, sind laut MissJourney, einer Initiative von TEDxAmsterdam Women und der Agentur ACE, weniger als 20 % der Bilder von Frauen. Sie können sich vorstellen, wie hoch der Prozentsatz an PoCs, Menschen mit Behinderungen oder Menschen, die ein anderes Geschlecht als männlich und weiblich haben, sein wird.

Die gleichen Tipps und Tricks für AI-Texte können auch hier angewendet werden. Fragen Sie in Ihrem Prompt nach inklusiven Bildern. Seien Sie aufmerksam, wenn Sie das erstellte Bild überarbeiten. Prüfen Sie nicht nur, ob es Ihrer Anfrage entspricht, sondern auch, ob es die moderne Gesellschaft korrekt widerspiegelt. Wenn nicht, verfeinern Sie Ihren Prompt, bis das Bild es tut. Wenn Sie auf der Suche nach Porträts sind, können Sie auch das KI-Tool von MissJourney verwenden. Es beschreibt sich selbst als die “KI-Alternative, die Frauen+ feiert”.

Das Bildmaterial, das Midjourney für den Prompt “portrait of a lawyer” erstellt hat.

Das Bildmaterial, das MissJourney für den Prompt “portrait of a lawyer” erstellt hat.

Gehen wir gemeinsam gegen Biases in der KI vor!

Die Bekämpfung von Biases in Texten ist viel mehr als nur die Suche nach geschlechts- oder rassenspezifischen Ungleichheiten. Es geht auch um die kleinen Dinge, die oft unbewusst und verinnerlicht sind und daher leicht übersehen werden können.

Als Content Creators und Texter:innen ist es unsere Aufgabe, dafür zu sorgen, dass wir Inhalte erstellen, die Vielfalt wertschätzen und für alle Menschen, unabhängig von ihrem Hintergrund oder ihrer Identität, relevant und unterstützend sind. Verwenden Sie Prompts, die ChatGPT oder anderen KI-Tools dabei helfen, integrative Texte zu erstellen, geben Sie den Tools Feedback, und überprüfen Sie allen Output kritisch. Nur so können Sie Inhalte erstellen, welche die moderne Gesellschaft genau widerspiegeln.

Mehr entdecken

Fragen?

Management